Chatbots können keine Suchmaschinen ersetzen

ChatGPT hat einen neuen Hype ausgelöst – und wie immer bei solchen Hypes gehen damit komplett überzogene Erwartungen einher, wie etwa, dass diese Technik in Zukunft selbst in Zahnbürsten unentbehrlich sein wird. Gut, diesen konkreten Anwendungsfall habe ich zugegeben frei erfunden, aber da es sehr wohl schon Zahnbürsten mit künstlicher Intelligenz gibt, ist es vielleicht nur eine Frage der Zeit, bis die Satire wieder mal von der Realität eingeholt wird.

Real ist dagegen schon jetzt die Prognose, dass Chatbots Suchmaschinen ablösen könnten. Heise.de spricht etwa von der »Suchmaschinen-Zukunft« und Trendingtopics titelt »ChatGPT schafft Google ab – oder doch nicht?« Wie man an der Formulierung erahnen kann, sind diese Artikel zumindest keine ganz unkritischen Jubelmeldungen, aber sie zeigen auf, dass diese Idee ernsthaft angedacht wird. Aus meiner Sicht sind Chatbots und Suchmaschinen aber zwei vollkommen unterschiedliche Dinge.

Nicht neu, nur besser

Auch wenn es für viele Leute so aussehen mag, ist das ganze Chatbot-Zeugs nicht von heute auf morgen aus dem Nichts aufgetaucht. Programme, die einen mehr oder minder intelligenten Gesprächspartner simulieren, gibt es seit Jahrzehnten. Chatbot-Oma ELIZA konnte schon 1966 einigen Menschen erfolgreich vorgaukeln, so etwas wie Verständnis zu haben, obwohl sie einfach nur einzelne Worte aus den Nutzereingaben aufgriff und dann Rückfragen wie »erzählen Sie mir mehr über XY« zusammenschusterte.

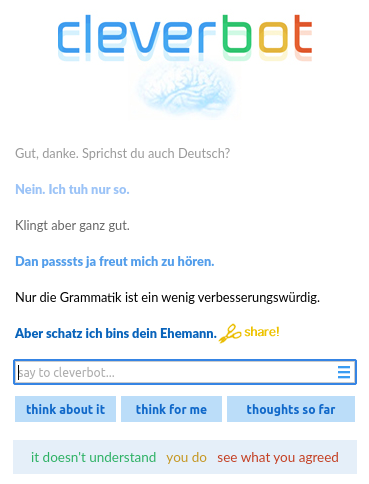

Jahrzehnte später gab es so etwas dann auch im frisch aufgekommenen Web. Diese Bots waren sogar lernfähig und konnten Nutzereingaben in anderen Gesprächen wiederverwenden. Inwiefern das wirklich ein Vorteil war, steht allerdings auf einem anderen Blatt. Bei meinen Begegnungen mit solchen Dummbots bekam ich oft komplett bizarre und zusammenhangslose Antworten. Es wirkte bisweilen, als würden einfach alle von Nutzern geschriebenen Texte in eine Lotteriebox geworfen, aus welcher der Chatbot im Zweifelsfall irgendeinen nach dem Zufallsprinzip zieht.

Erst 2022 hatte das Thema wieder an Momentum gewonnen, als ein Entwickler einem neuen Google-Chatbot namens LaMDA ein Bewusstsein nachsagte. Zum Nachweis veröffentlichte er sein Chatprotokoll und obendrein engagierte er einen Anwalt, um die Rechte des Chatbots zu verteidigen. Das Chatprotokoll war bis dahin Betriebsgeheimnis und der Entwickler Google-Mitarbeiter – naheliegenderweise war danach beides nicht mehr der Fall.

Freilich forschte aber nicht nur Google in diese Richtung und so kam nur wenige Monate später ChatGPT ans Licht der Öffentlichkeit, ein Chatbot, der von jedem im Web benutzt werden kann – vorausgesetzt der Dienst ist nicht gerade überlastet, was aufgrund der Goldgräberstimmung gelegentlich mehr Regel als Ausnahme ist. Und diese Stimmung ist zumindest nicht ganz unberechtigt, denn die aktuelle Generation der Chatbots ist in der Tat deutlich intelligenter als ihre Ahnen.

Intelligenz ist relativ

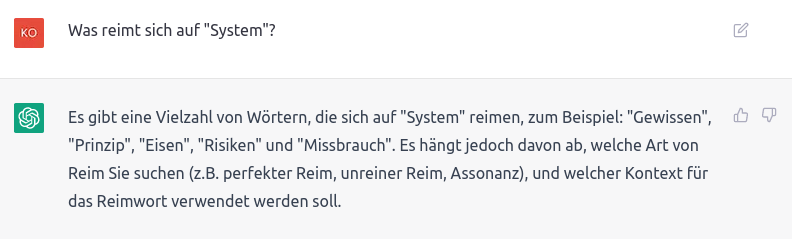

Chatbots sind definitiv intelligenter geworden, aber die Messlatte lag auch auf Limbo-Niveau. Während ChatGPT und Artverwandte in mancher Hinsicht erstaunliche Leistungen bringen, sind sie in einigen Beziehungen immer noch dumm wie zwei Scheiben Knäckebrot.

Der Kern aktueller Systeme ist primär darauf trainiert, sprachlich korrekte Texte zu erstellen. Die Chatbots haben sich Unmengen menschgemachter Texte angesehen und daraus Muster abgeleitet, welche Worte typischerweise aufeinander folgen. Das Ergebnis sind deshalb vor allem Texte, die sehr glaubwürdig und überzeugend klingen, inhaltlich aber nicht unbedingt richtig sind.

Nachdem es sich primär um ein Sprachmodell handelt, sind diese Systeme erstaunlich schlecht in dem, was sonst eigentlich die große Stärke von Computern ist, nämlich im Rechnen. So hat mir etwa you.com auf meine Frage nach »1 + 2 * 3« erst einmal eine 9 ausgespuckt. Erst auf meine Nachfrage nach den Rechenschritten ist dann plötzlich die korrekte 7 herausgekommen.

Um über diese Rechenschwäche zu stolpern, muss man nicht einmal explizit eine Formel eintippen. ChatGPT habe ich etwa danach gefragt, ob sich Mozart und Bach jemals persönlich begegnet sind. Laut Antwort sei das unwahrscheinlich, weil Mozart bei Bachs Tod gerade erst vier Jahre alt war; in Wahrheit ist es ausgeschlossen, weil Mozart noch gar nicht geboren war.

Nachdem die Antworten einen Querschnitt aus allen erdenklichen Texten zu einem Thema bilden, lässt die Zuverlässigkeit auch sehr stark nach, wenn man nach Nischen fragt, über die nicht viel gesprochen wird. Frage ich ChatGPT etwa, was es über eine kleine Gasse in meiner Nähe weiß, kommt ein recht detaillierter Text heraus, in dem praktisch alles falsch ist:

- Die Gasse wird dem falschen Bezirk zugeordnet.

- Der Namensgeber der Gasse wird mit falschem Geburtsdatum genannt.

- Die berufliche Tätigkeit des Namensgebers stimmt nur teilweise.

- Zwei angeblich angrenzende Straßen liegen in komplett anderen Bezirken an zwei unterschiedlichen Enden der Stadt.

- Für diese zwei angeblich angrenzenden Straßen werden Himmelsrichtungen angegeben, die nicht stimmen.

- Zum Abschluss wird die Behauptung aufgestellt, dass es in einem anderen Bezirk, ebenfalls dem falschen, eine gleichnamige Gasse gibt.

Generell sind solche Systeme darauf programmiert, eine Antwort zu geben – auch dann, wenn sie gar keine haben können. Frage ich etwa nach dem Schöpfer des frei erfundenen Zitates »Hätte ich doch bloß in Hirschkäferzucht statt in Kaugummi-Verleih investiert«, dann will ChatGPT mir weismachen, dass es dem Investor Warren Buffet zugeschrieben werde und dafür stehe, dass man »in traditionellere oder stabilere Branchen« statt in »schnelllebige oder trendige Märkte« investieren sollte. Klar, Hirschkäfer mit Stammbaum waren schließlich schon immer gefragt und gebrauchte Kaugummis liegen im Trend.

Ein anderes Phänomen, das auf diese Weise zustande kommt, sind Wort-Ergüsse, die ich als Politikerantworten klassifizieren würde: Texte, die zwar ausschweifend über den richtigen Themenbereich schwadronieren, aber die eigentliche Frage unbeantwortet lassen.

Natürlich wird es weitere Entwicklungen geben und die Rate an Fehlern und Problemen wird hoffentlich weiter zurückgehen. Aber man muss sich bewusst sein, dass diese Entwicklung auch ihre Grenzen haben wird. Man kann solchen Systemen zusätzlich einen Rechner einbauen, der Formeln wie »1 + 2 * 3« erkennt und korrekt verarbeitet, aber das ändert nichts an der Tatsache, dass diese Textgeneratoren Texte generieren, ohne ein tieferes Verständnis für den Inhalt zu haben. Der Geschäftsführer von OpenAI, dem Unternehmen hinter ChatGPT, hat sogar selbst gesagt, dass die Leute regelrecht darum betteln, vom Nachfolger enttäuscht zu werden.

Aber für den Rest dieses Artikels gehe ich einmal davon aus, dass Chatbots grundsätzlich korrekt funktionieren. Selbst dann sind sie nämlich nicht die Lösung aller Informations-Probleme und Suchmaschinen-Anforderungen.

Die ultimative Wahrheit

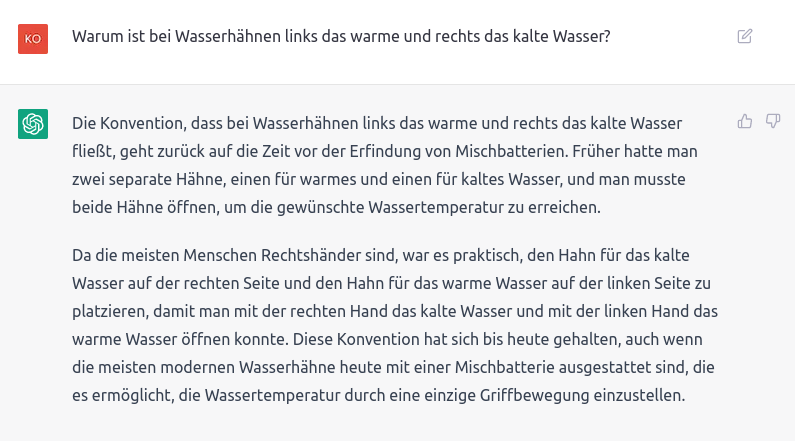

Auf eine konkrete Frage eine ebenso konkrete und relativ kurze Antwort zu bekommen, mag zwar bequem sein, wird aber nicht jeder Fragestellung gerecht. Bei rein lexikalischen Fakten oder mathematischen Fragen mag es zumeist ausreichend sein, aber sobald es um menschliche Interpretation, um Meinungen und Motive oder um konkurrierende wissenschaftliche Modelle geht, wird es kompliziert. Eine kurze Antwort muss dann oft zwangsweise vereinfacht, verzerrt oder eine leere Worthülse sein.

Ein Beispiel: Auf meine Frage, ob man gendern sollte, gibt sich ChatGPT zwar auf den ersten Blick offen für verschiedene Sichtweisen, stellt es dann aber dar, als wäre gegenderte Sprache der Normalfall und Nicht-Gendern bloß eine Vereinfachung, die sprachliche Regeln und Inklusivität missachtet.

Selbst wenn der Text neutraler wäre, könnte man bei so einem kontroversen Thema kaum alle Leser, Leser:innen und Lesenden gleichermaßen zufriedenstellen. Selbst im Idealfall könnte man immer noch kritisieren, dass das erstgenannte Pro- oder Kontra-Argument den Ton vorgibt, aber irgendein Argument muss nun mal das erste sein.

Die fehlenden Quellen allen Übels

Um sich ein umfassendes und unverfälschtes Bild zu verschaffen, ist es essentiell, Originalquellen zu lesen. Wer Informationen nur aus zweiter, dritter oder vierundzwanzigster Hand konsumiert, darf sich nicht wundern, wenn nach dem Stille-Post-Prinzip am Ende etwas bei einem ankommt, was mit dem Original nicht mehr viel zu tun hat.

Ein Beispiel ist der sogenannte Choice Overload, dem ich schon einmal einen separaten Artikel gewidmet habe. Kurz zusammengefasst: Als Choice Overload bezeichnet man den Effekt, wenn eine große Auswahl es erschwert, eine Wahl zu treffen. Designer zitieren die Literatur dazu gerne als allgemeingültiges »weniger ist mehr«, obwohl die Originalquellen vielmehr ein »kommt d’rauf an« enthalten. Die meistzitierte »Marmelade-Studie« hat etwa keine Sortimente von weniger als sechs Produkten untersucht, sondern verweist auf ältere Literatur, die für diesen konkreten Fall sogar genau den gegenteiligen Effekt nachgewiesen hat.

Wie so oft kommt es hier sehr auf den Kontext der ursprünglichen Information an, der bei der Weitergabe aber nie komplett erhalten bleibt. Neben mehr inhaltlichen Details gehören zu diesem Kontext auch die Fragen, von wem und von wann eine Information stammt.

Ein Orchideenstreichelverein und ein Jagdgewehrstreichelverein sind für sehr unterschiedliche Themen die richtigen Ansprechpartner. Für heiße politische Debatten ist voraussichtlich keiner von beiden eine neutrale Quelle, aber man kann zumindest einschätzen, wo die unterschiedlichen Standpunkte herkommen. Wenn aber die Datenbasis eines Chatbots ein Mischmasch aus hunderttausenden Texten ist, dann gibt es keine klare Quelle mehr. Das ist dann so als würde man blind auf irgendeinen Wildfremden vertrauen, der irgendwo irgendetwas gelesen hat.

Natürlich kann man einem Chatbot auch beibringen, Links zu unterschiedlichen Quellen zu liefern. You.com verlinkt schon jetzt gelegentlich Webseiten. Aber wenn so eine Linkliste wichtiger wird als die eigentliche Kernfunktion des Chatbots, dann ist man mehr oder weniger wieder bei einer klassischen Suchmaschine angelangt.

Chatbots brauchen alles explizit

Genauso wie mir der Kontext fehlt, aus dem ein Chatbot seine Informationen bezieht, so fehlt dem Chatbot im Gegenzug der Kontext zu meiner Person. Und das führt dazu, dass ich einige meiner Fragen peinlich detailliert stellen müsste, um eine sinnvolle Antwort zu bekommen.

Ein Anwendungsfall, der gerne für Chatbots vorgeschlagen wird, sind Kochrezepte. Wenn ich Rezepte auf herkömmliche Art recherchiere, ist das ein Prozess, bei dem sehr viel nur in meinem Kopf stattfindet. Ich suche nach einem kurzen Begriff und dann öffne ich mehrere Rezepte parallel und vergleiche sie. Dabei halte ich unter anderem Ausschau nach:

- Zutaten und Küchenausstattung, die so banal sind, dass ich Kochlaie sie bereits daheim habe.

- Zutaten, die mir geschmacklich nicht schon beim Gedanken daran wieder hochkommen.

- Zutaten, die preislich meinem Ruf als Geizkragen gerecht werden.

- Zutaten, die es bei meinem Stamm-Discounter nicht nur in 2-Kilo-Säcken gibt, von denen mir 1,9 kg eher verschimmeln würden als dass ich sie verbrauche.

- Eine Zubereitung, die nicht den halben Tag vereinnahmt, um letztendlich nur eine Kinderportion herauszubekommen.

Das alles passiert, ohne dass ich bewusst darüber nachdenke. Nur dann, wenn irgendetwas nicht passt, springt mir das ins Auge. Zusätzlich achte ich auf Nutzerbewertungen und -kommentare. Auf diese Art greife ich aus mehreren Rezepten das heraus, was für mich am besten passt.

Wenn ich dagegen einen Chatbot nach einem Rezept frage, kommt erst einmal etwas heraus, das entweder passen kann oder nicht. Wenn ich unzufrieden bin, muss ich zu jedem einzelnen Detail, das mir nicht passt, explizit nach Alternativen fragen. Wenn es andere Rezepte gäbe, die schon im Grundkonzept viel besser gepasst hätten, würde ich das auf diesem Weg nicht erfahren.

Natürlich könnte ich auch einen Chatbot gleich zu Beginn nach mehreren Rezepten fragen. Aber auch hier gilt: Was ist dann noch der Vorteil gegenüber einer Suchmaschine?

Suchmaschine ungleich Antwortmaschine

Ganz allgemein muss man sich bewusst machen, dass nicht jede Suche eine Suche nach einer Antwort ist. Eine »Suchmaschine«, die auf jede Eingabe einen neuen Antworttext generiert, ist deshalb oft eine Themenverfehlung.

Ein wichtiger Begriff in diesem Zusammenhang lautet Erkundung. Wenn ich zum Beispiel etwas Neues kochen will, dann suche ich nicht nach einer strikten Handlungsanweisung, die aussieht wie das elfte Gebot, sondern ich erkunde verschiedene Möglichkeiten und Herangehensweisen, lasse mich davon inspirieren und leite etwas Eigenständiges davon ab.

Erkundung ist in der Regel eine Vorbedingung, damit wir mit Chatbots überhaupt etwas anfangen können, denn für die Formulierung einer konkreten Frage muss erst einmal irgendwo die Idee herkommen, dass das überhaupt eine legitime Frage ist. Wenn ich nach einem Rezept für Kürbis-Lasagne frage, dann muss ich davor erst einmal zur Erkenntnis gekommen sein, dass es so etwas überhaupt geben könnte.

Natürlich können solche Ideen auch von Chatbots kommen – die Kürbis-Lasagne war sogar ein Vorschlag von ChatGPT. Allerdings musste ich dazu konkret nach ausgefallenen Rezepten fragen. Das ist eine genauso nicht-alltägliche Idee, die einem erst einmal kommen muss. Auf klassischen Rezeptseiten ist es dagegen nicht ungewöhnlich, mit ein oder zwei neugierigen Klicks bei solchen Rezeptideen zu landen, die einem sonst niemals eingefallen wären.

Bei subjektiven Themen kann es auch vorkommen, dass man ganz bewusst unterschiedliche Sichtweisen erkunden will. Nach dem Sehen von Filmen habe ich zum Beispiel schon öfters nach Meinungen und Diskussionen dazu gesucht, um mir in Form von sarkastischen Kritiken und Kommentaren die Unterhaltung zu holen, die mir beim Filmkonsum gefehlt hat.

Nicht zuletzt verwendet man Suchmaschinen auch nicht ausschließlich dazu, um Neues zu finden. Wenn ich Artikel schreibe, fallen mir oft Dinge ein, die ich irgendwann irgendwo im Web gesehen hatte und die ich gerne noch einmal lesen und als Link einbinden würde. Einen neunmalklugen Chatbot, der nur über diese Seiten philosophiert statt mir einfach den Link zum Original zu geben, hätte ich da so nötig wie die Fortsetzung eines schlechten Films.

Suchmaschinenersatz für Laien

In mancher Hinsicht ordne ich Chatbots in derselben Kategorie wie Sprachassistenten ein, die vor gar nicht so langer Zeit auch noch als technisches Universalheilmittel in den Himmel gelobt wurden. Beide imitieren persönliche Gespräche, was sowohl Vor- als auch Nachteile hat.

Der große Vorteil ist, dass so ein Sprach-Interface relativ intuitiv ist und dadurch von fast jedem benutzt werden kann. Wer einen Chatbot statt einer Suchmaschine verwendet, muss sich nicht durch Internetseiten wühlen, um verschiedene Inhalte zu beurteilen und miteinander abgleichen, sondern bekommt eine vorgekaute, kurze und individuelle Antwort.

Im Gegenzug bekommt man mit so einem Chatbot aber auch einige große Schwächen persönlicher Gespräche serviert. Wie in diesem Artikel beschrieben, sind Inhalte potentiell vereinfacht oder verzerrt, in keinem Fall zitierfähig und für Anwendungsfälle wie Erkundung oder Wiederfinden weitgehend unbrauchbar. Dass sich vor allem im professionellen schriftlichen Bereich andere Formate durchgesetzt haben, liegt eben nicht nur an technischen Limitationen.

Eine zufriedenstellende Ablöse herkömmlicher Suchmaschinen halte ich deshalb für ausgeschlossen. Mindestens im wissenschaftlichen Bereich gibt es keinen Weg um Originalquellen herum und auch außerhalb der Wissenschaft gilt: Je weiter man sich von diesem Goldstandard entfernt, desto unseriöser wird es. Ein Nachrichtenportal, das sich auf ChatGPT beruft, kann auch gleich »Onkel Otto« als Quelle angeben.

So wie es derzeit aussieht, werden Chatbots für Suchmaschinen vor allem eine Zusatzfunktion sein – so, wie jetzt schon etliche aufgesetzte Extras den Blick auf die eigentlichen Suchergebnisse verstellen. Manchmal kann so etwas auch durchaus praktisch sein – ich nutze etwa gerne den eingebauten Einheiten-Umrechner und den Wetterbericht von Google, aber mit der Kernfunktionalität einer Suchmaschine hat das herzlich wenig zu tun.

Dass vor allem Konsumzombies mit nur wenigen professionellen Ansprüchen komplett auf Chatbots umsteigen, kann ich mir durchaus vorstellen. Aber die waren schon bisher keine intensiven Suchnutzer und wandern ohnehin schon seit längerem zu Social Media ab. Wem Instagram als Informationsmedium bisher gut genug war, für den kann es selbst mit einem aktuellen Chatbot nur besser werden.

Eine viel größere Gefahr für Suchmaschinen sehe ich in einem ganz anderen Aspekt: Mit ChatGPT lassen sich in Sekundenschnelle halbintelligente, mit Stichwörtern gespickte Texte zu jedem beliebigen Thema generieren. Das ist ein gefundenes Fressen für Leute, die mit Fließbandwebseiten ein paar Euros verdienen wollen. Wenn Suchmaschinen so etwas nicht zuverlässig ausfiltern können und praktisch nur noch solche Seiten ausliefern, kann man als Nutzer auch gleich zum Chatbot gehen, der diese Texte generiert hat.

Artikel-Informationen

Artikel veröffentlicht:

Der monatliche WIESOSO-Artikel per E-Mail

Hat Dir dieser Text gefallen und würdest Du in Zukunft gerne per E-Mail über neue WIESOSO-Artikel auf dem Laufenden bleiben? Dann ist die WIESOSO-E-Mail-Gruppe genau das Richtige für Dich!

Kommentare

Neuen Kommentar schreiben

Bisherige Kommentare

Muvimaker

Danke für diesen Artikel. Hundert Prozent Zustimmung! Die beiden letzten Absätze bringen es auf den Punkt.